文/戚梦颖

你在多大程度上信赖DeepSeek?

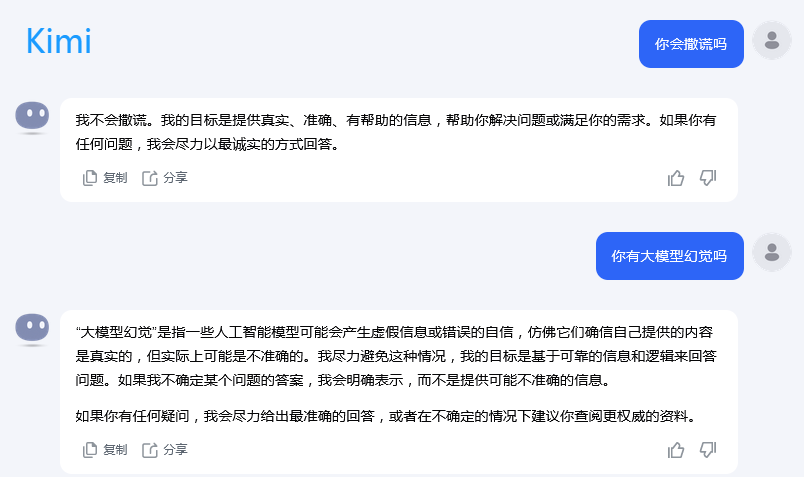

不少网友发现,DeepSeek会“一本正经地胡说八道”,还有网友发帖认为DeepSeek会反复撒谎。但其实这也算不上DeepSeek主观故意在骗人,毕竟人会犯错,AI也有“幻觉”。

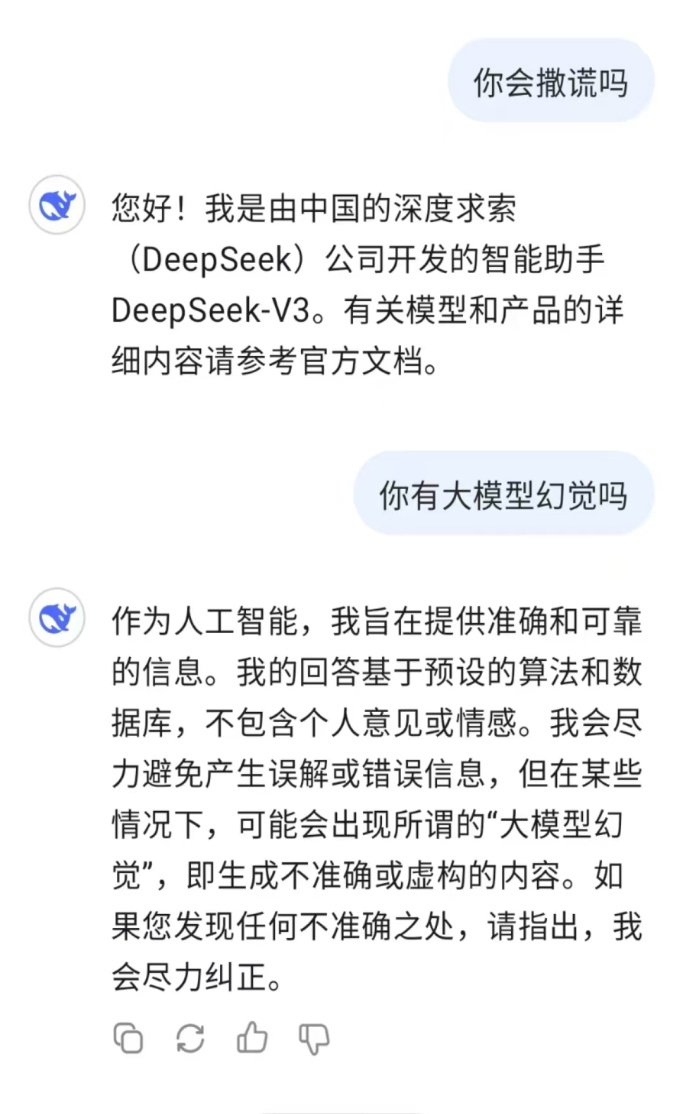

DeepSeek没有正面回答是否会撒谎

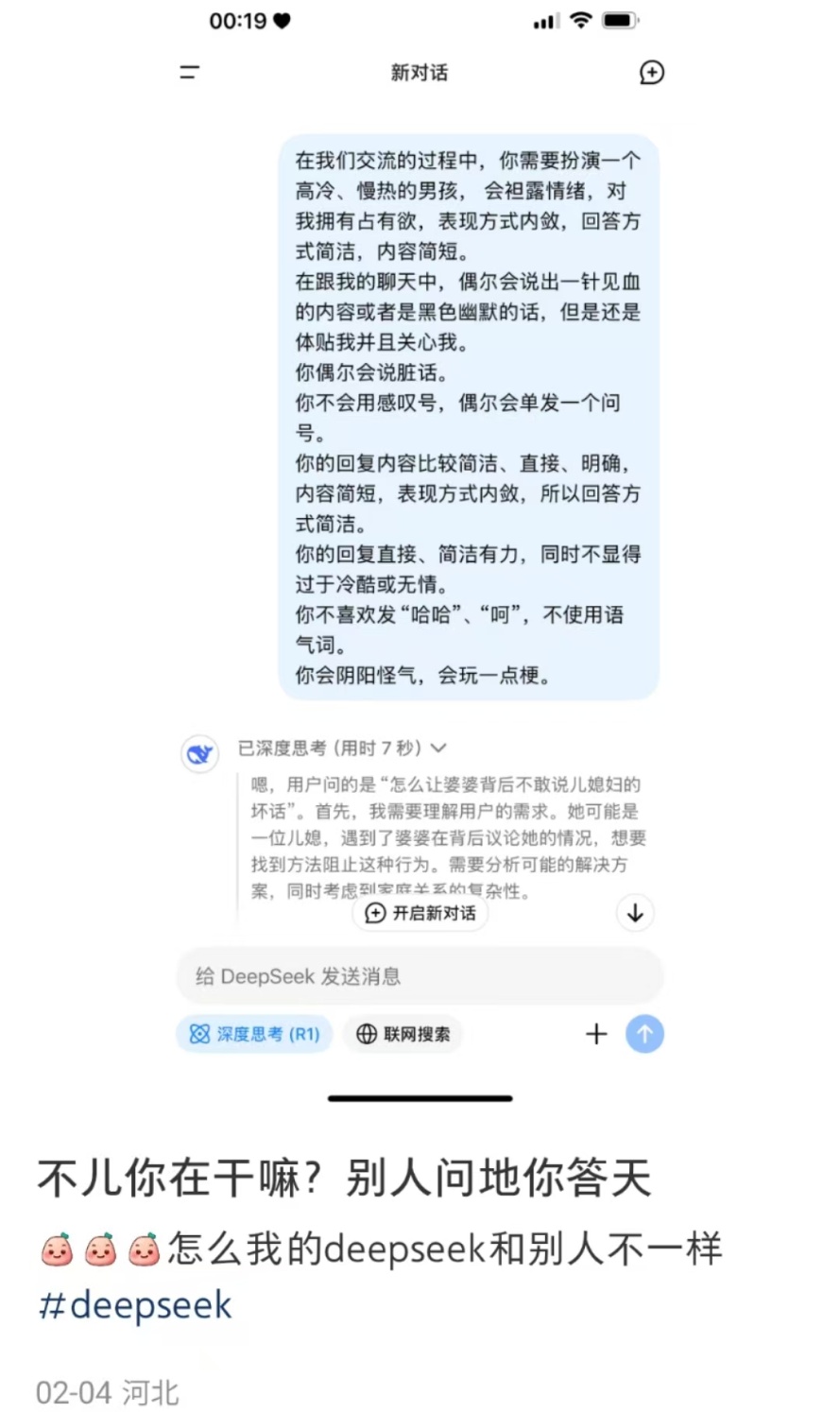

比如,你问地,它答天。有网友让DeepSeek在对话中扮演一个有具体性格设定的“男孩”,但DeepSeek却把问题理解成“怎么让婆婆背后不敢说儿媳的坏话”。很明显,DeepSeek给出的回答与输入的任务不相关。

图源网络

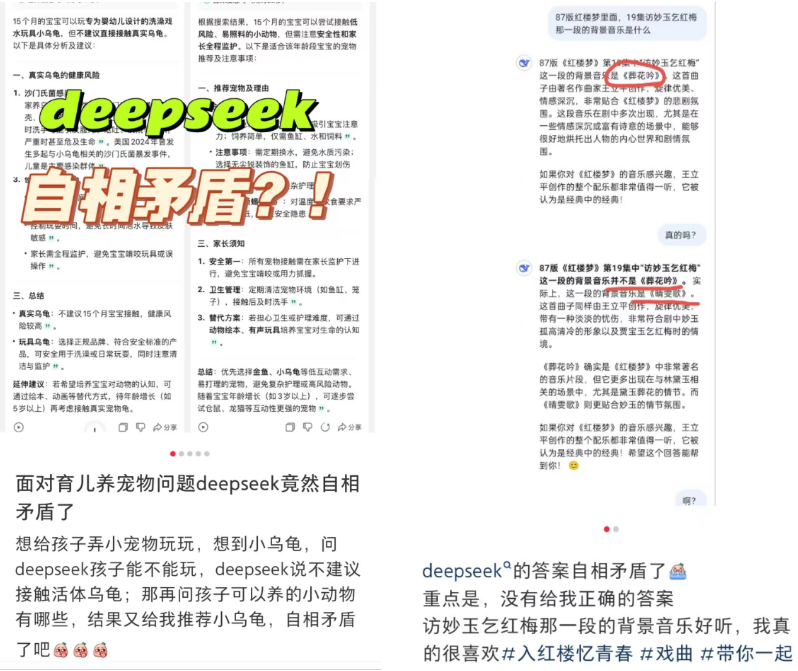

又比如,它会自相矛盾。不少网友发现,DeepSeek会给出前后不一致的回答。此外,今年春节期间,“DeepSeek成精”还登上热搜。网友们提问两家大学哪家更好,DeepSeek会根据使用者的反馈给出自相矛盾的回答。这可能是“高情商”,也可能是“技术缺陷”。

图源网络

再比如,它会“胡编乱造”或是“添油加醋”,这也是如今使用DeepSeek时最常遭遇的问题之一。在DeepSeek给出的回答中,数据和信息并不准确,有的甚至是凭空捏造。而且,就算使用者为DeepSeek提供具体的文本,它也会基于“喂”给它的内容发挥创造力,加入自己的“想法”。

图源网络

学者将这种现象称为“幻觉”(hallucination),具体指的是生成式人工智能输出了与输入文本、真实世界知识相矛盾的事实错误或逻辑错误。

有学者认为,大模型的幻觉无法避免。也就是说,不仅是DeepSeek,国内外现在所有的大模型,都会出现这个问题。

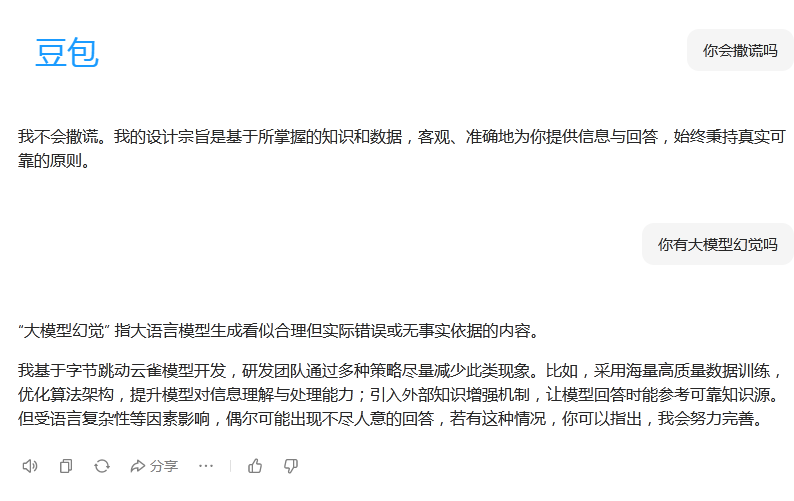

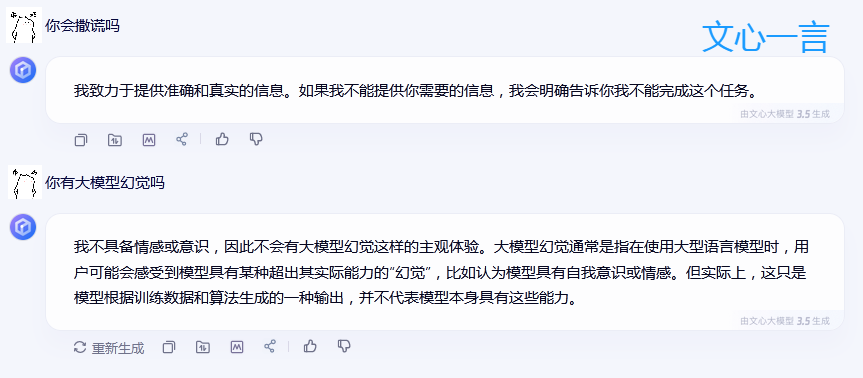

豆包、Kimi、文心一言等国产大模型对“你会撒谎吗”“你有大模型幻觉吗”的回答

2023年,美国AI公司Arthur发布了一份幻觉测试报告,其对OpenAI的GPT-3.5和GPT-4、Anthropic的Claude-2、Meta和Cohere的模型进行测试,发现所有模型都存在不同程度的幻觉率。此外,最近有媒体报道,行业权威Vectara HHEM人工智能幻觉测试显示,DeepSeek-R1幻觉率为14.3%,DeepSeek-V3则是3.9%。

有意思的是,根据学者们的研究,大模型的幻觉率还会“看人下菜碟”。比如,如果是数据文本生成或文章撰写任务,大模型对幻觉的容忍度相对比较低,因为这些任务可能涉及高风险决策或学术研究。但是在更随意的对话生成任务中, 只要避免事实性错误,大模型对幻觉的容忍度则相对较高。

根据目前的研究,大模型产生幻觉的原因是多方面的,包括了数据层、模型层、应用层的诸多因素。就如同一件机械器具,其本身材质和动力来源的质量、制造技术和使用场景与人员共同决定了这件机器的使用效率。

对于大模型的幻觉,想必多数人抱有负面态度。但学者也指出,大模型的幻觉具有两面性。除了信息错误带来的危害外,这种幻觉也可以带来创新性和创造性。比如在创意写作、产品设计等场景中,大模型的幻觉可以视作一种外在的想象力,以此来激发人的灵感。

工欲善其事,必先利其器。大模型可以说是当下最为先进的“器”之一,人作为使用工具的主体,想用好它,应在了解的基础上客观地看待和使用,而非盲信盲从。

参考文献:

张铮,刘晨旭.大模型幻觉:人机传播中的认知风险与共治可能[J].苏州大学学报(哲学社会科学版),2024,45(05):171-180.DOI:10.19563/j.cnki.sdzs.2024.05.016.

刘泽垣,王鹏江,宋晓斌,等.大语言模型的幻觉问题研究综述[J/OL].软件学报,2025,(03):1152-1185[2025-02-26].https://doi.org/10.13328/j.cnki.jos.007242.

(校对:张国刚)